概要

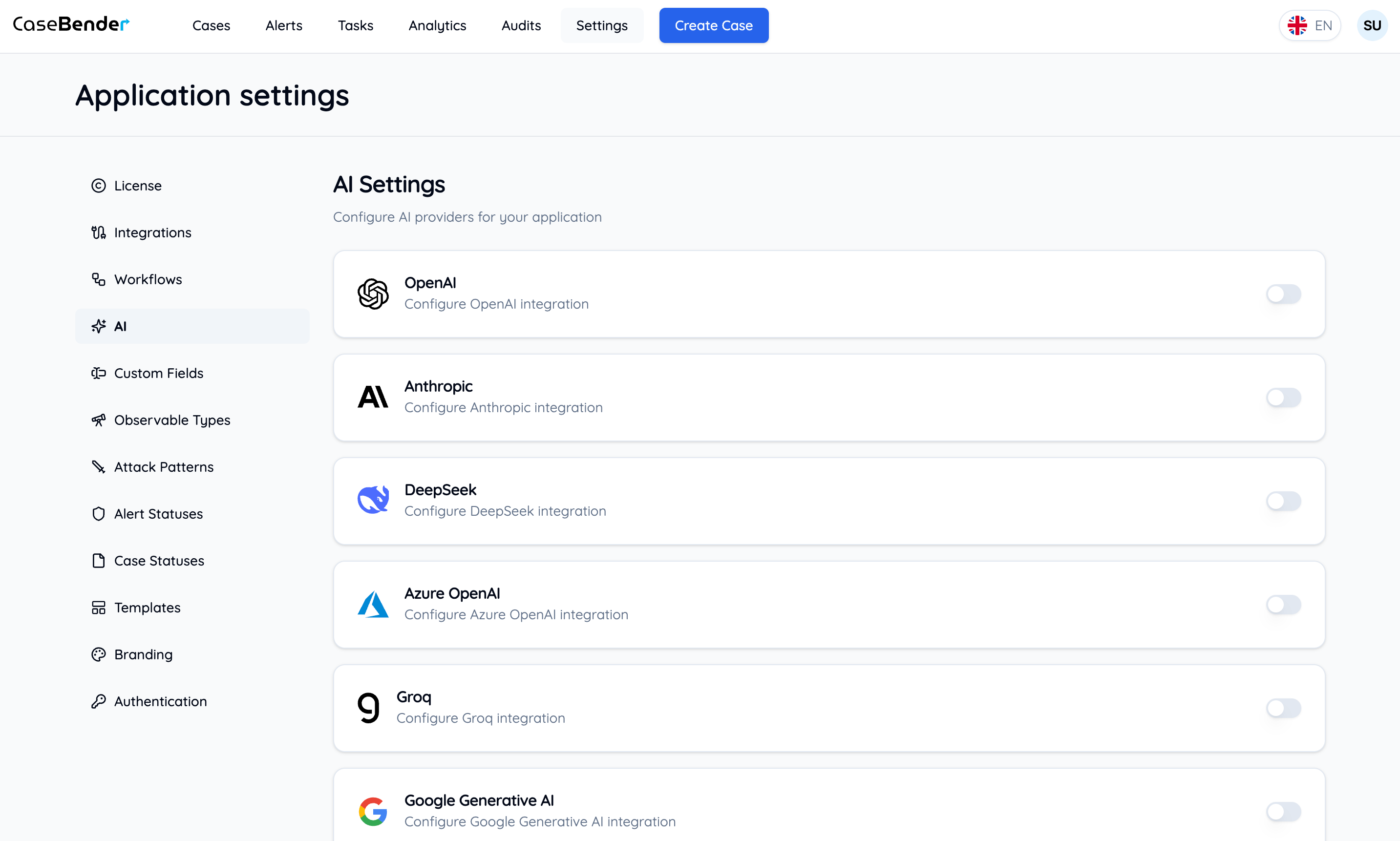

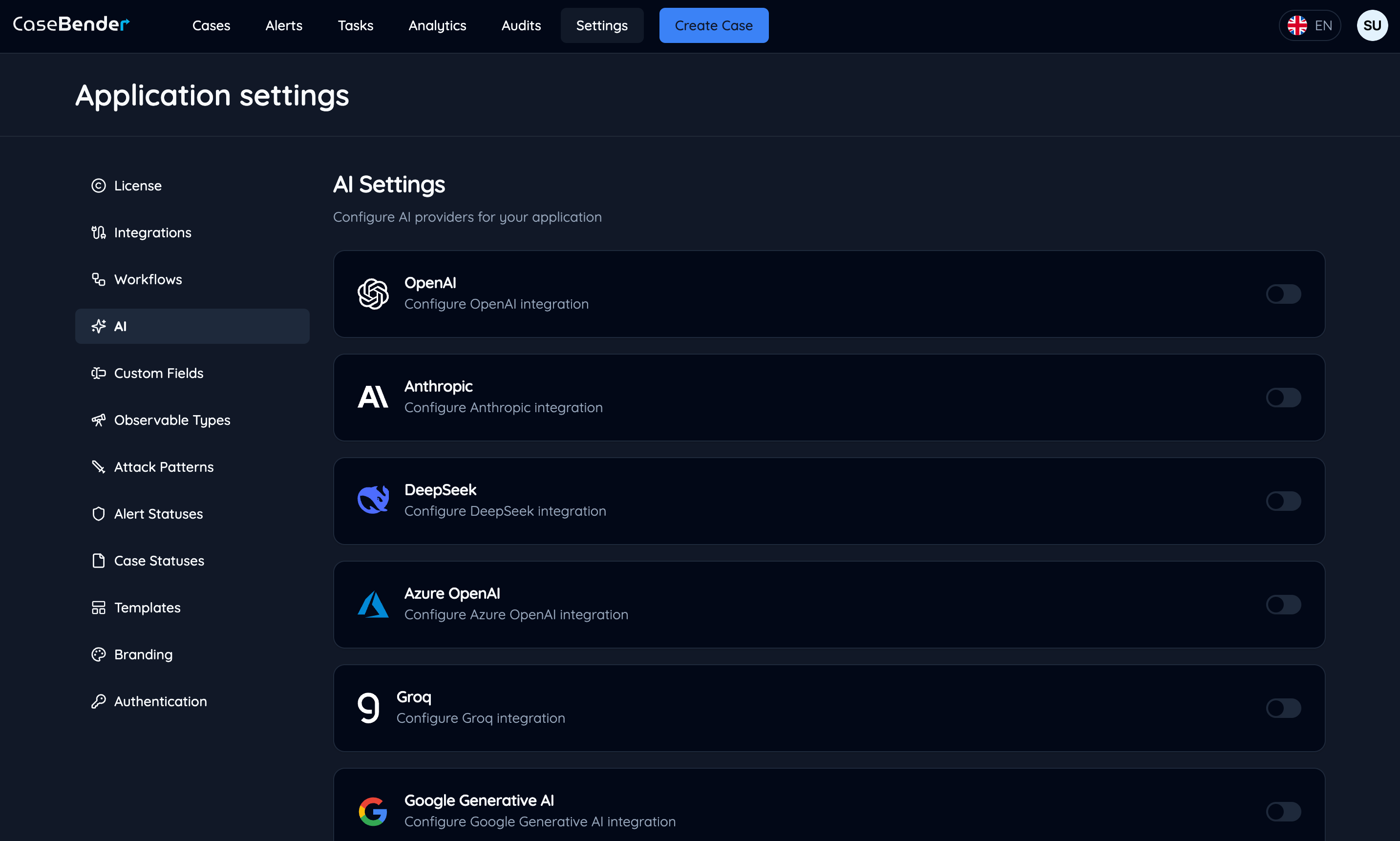

AI設定セクションでは、インテリジェント機能でCaseBenderエクスペリエンスを強化するために、様々なAIプロバイダーを構成することができます。これには、ケース分析、コンテンツ生成、自動処理などの機能を強化するためのOpenAI、Anthropicなどのプロバイダーの設定が含まれます。

AIプロバイダーの構成

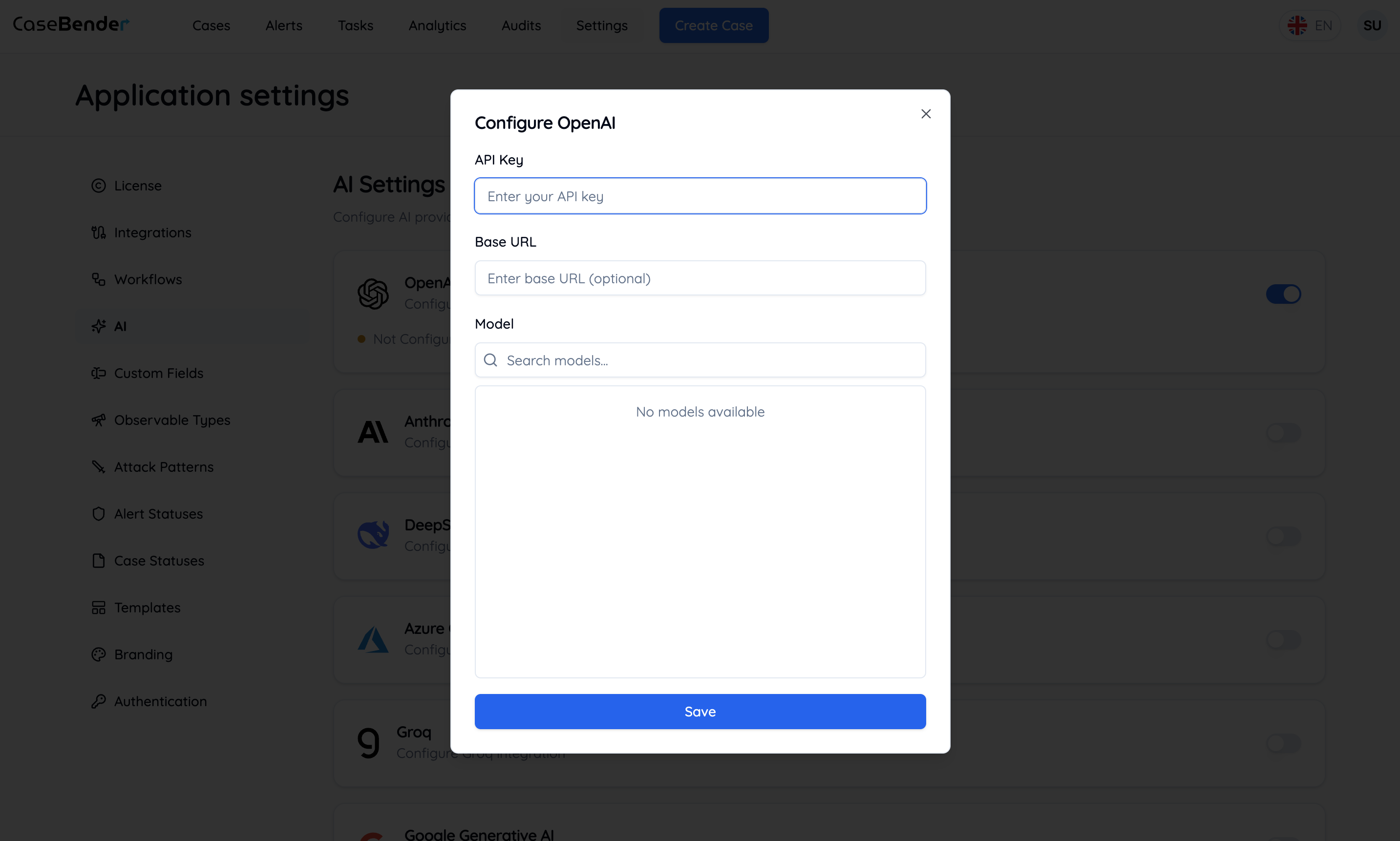

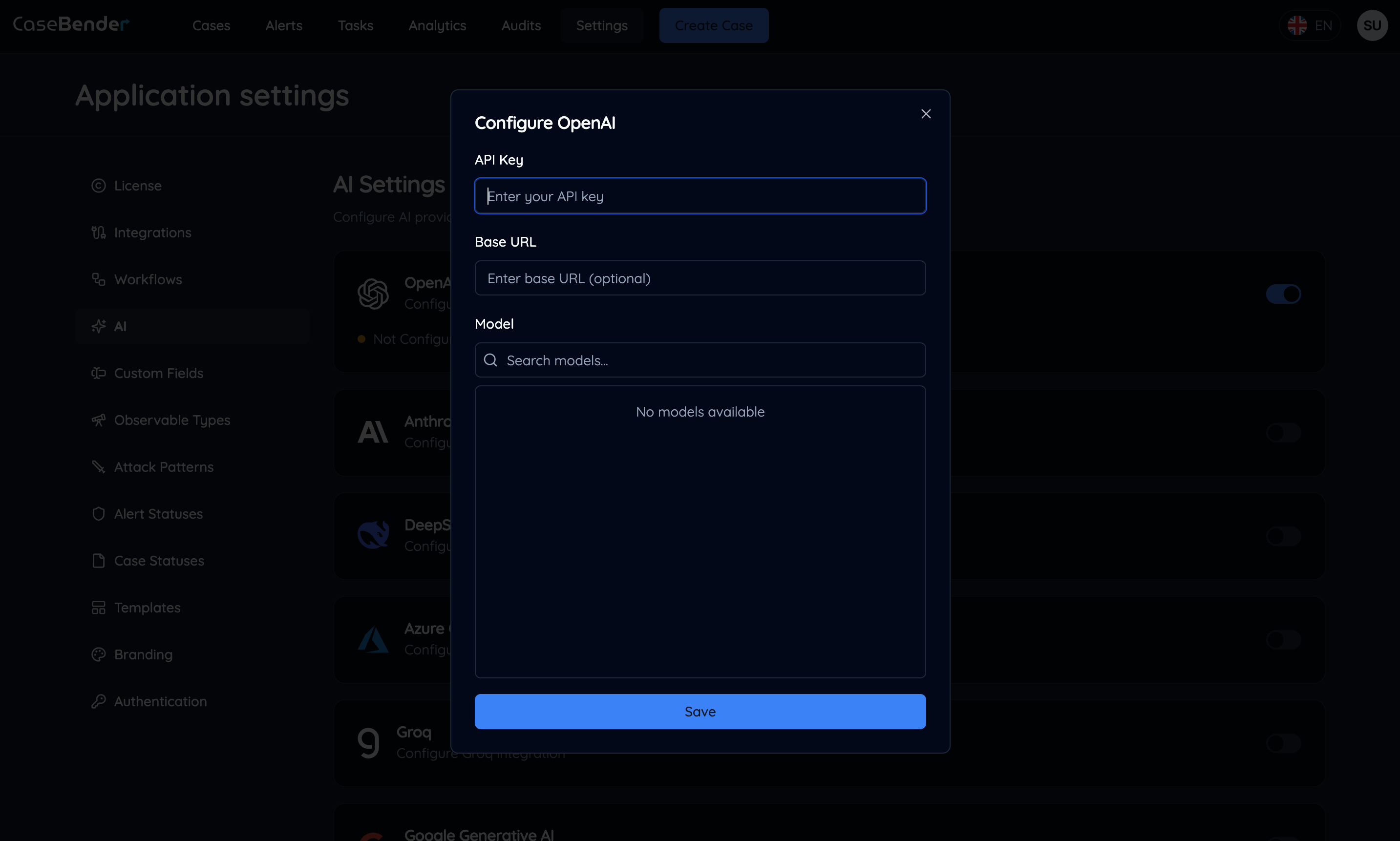

ステップ1:プロバイダーの有効化

AIプロバイダーの使用を開始するには、ダッシュボードでプロバイダーカードを見つけて有効化スイッチを切り替えます:

- APIキーの入力

- 基本設定の構成

- 使用制限の設定

- アクセス権限の定義

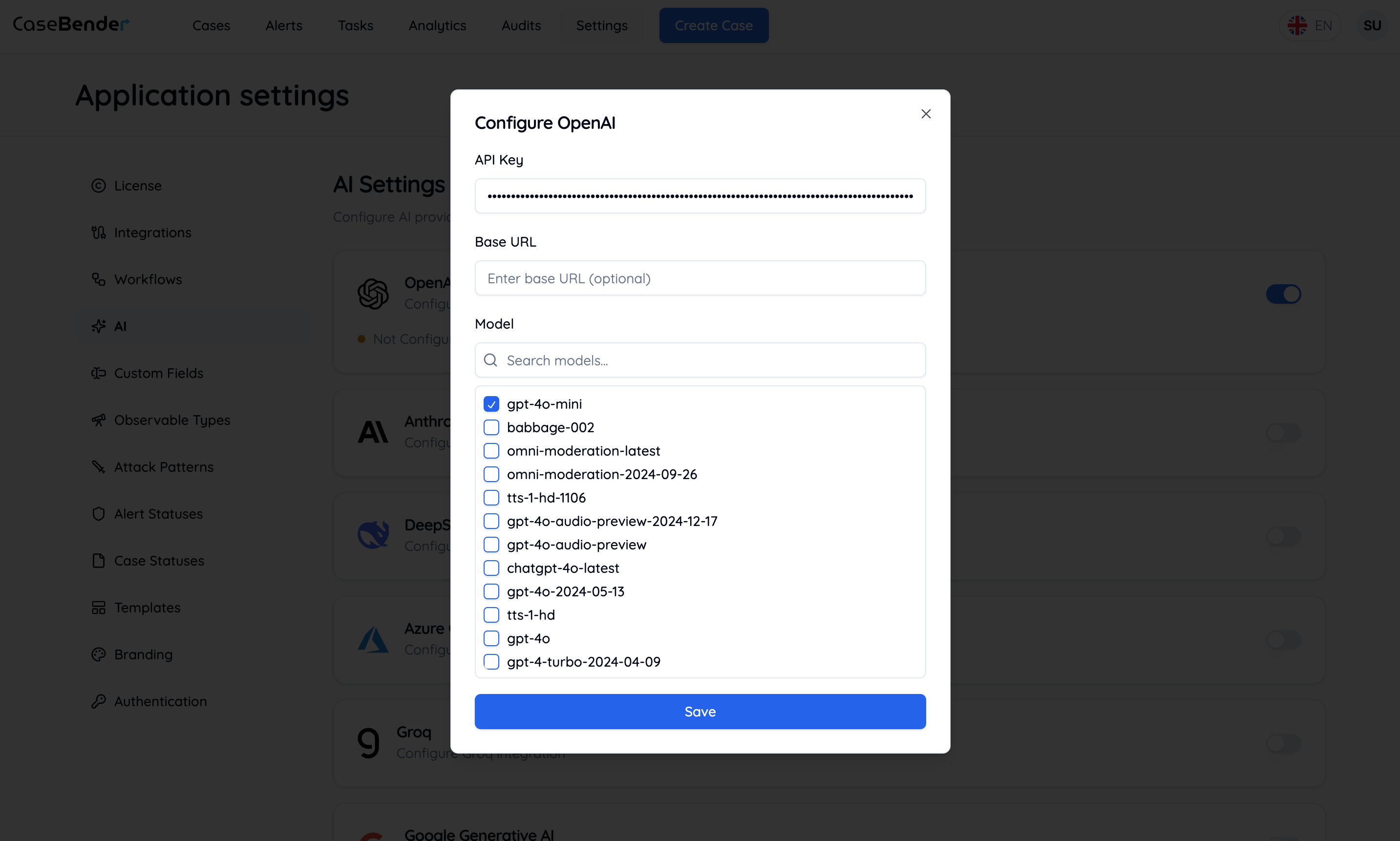

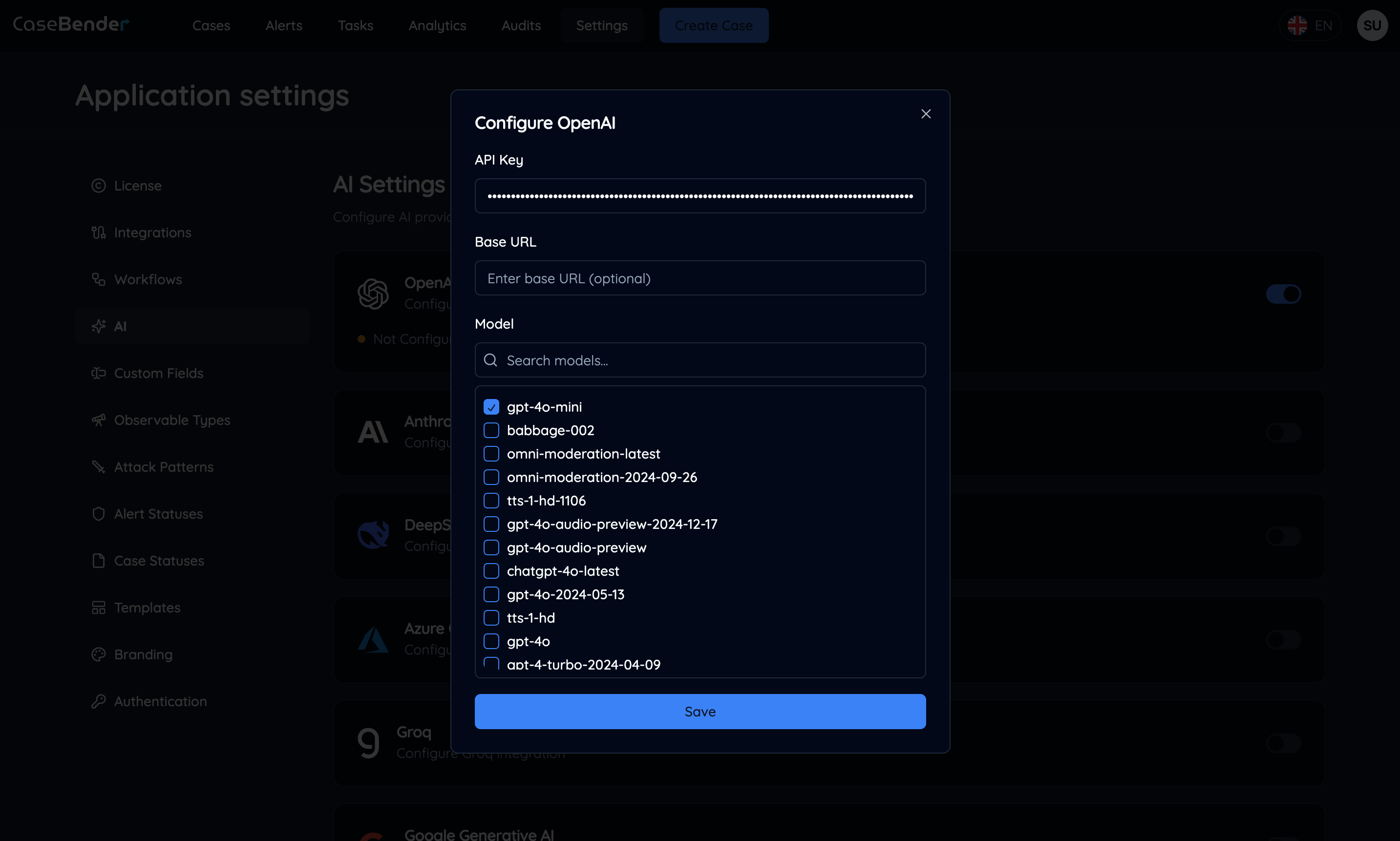

ステップ2:モデルの選択

有効なAPIキーを入力すると、プロバイダーで利用可能なモデルが表示されます:

- 優先モデルの選択

- モデル固有のパラメータの設定

- 使用クォータの構成

- モデルアクセス権限の定義

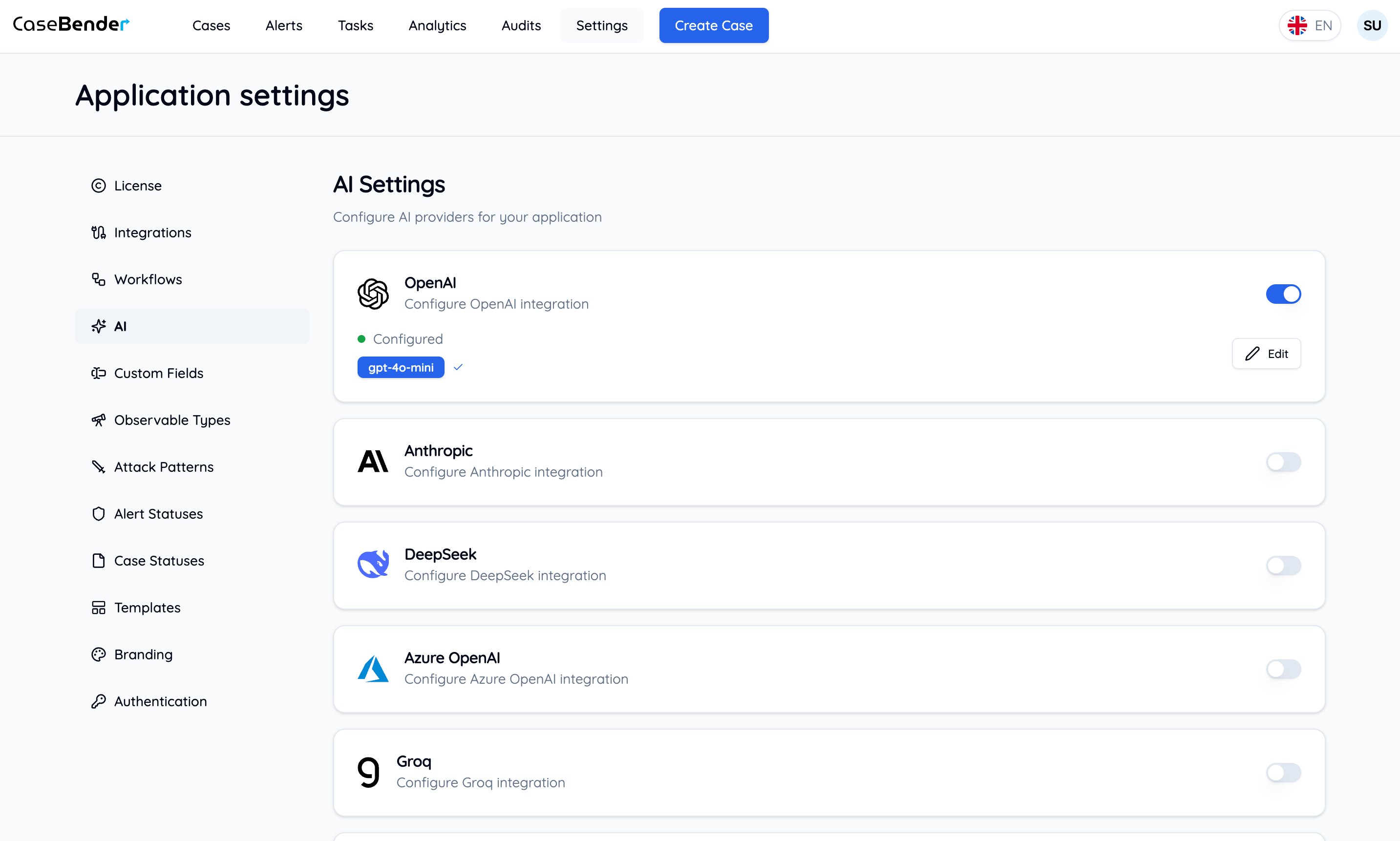

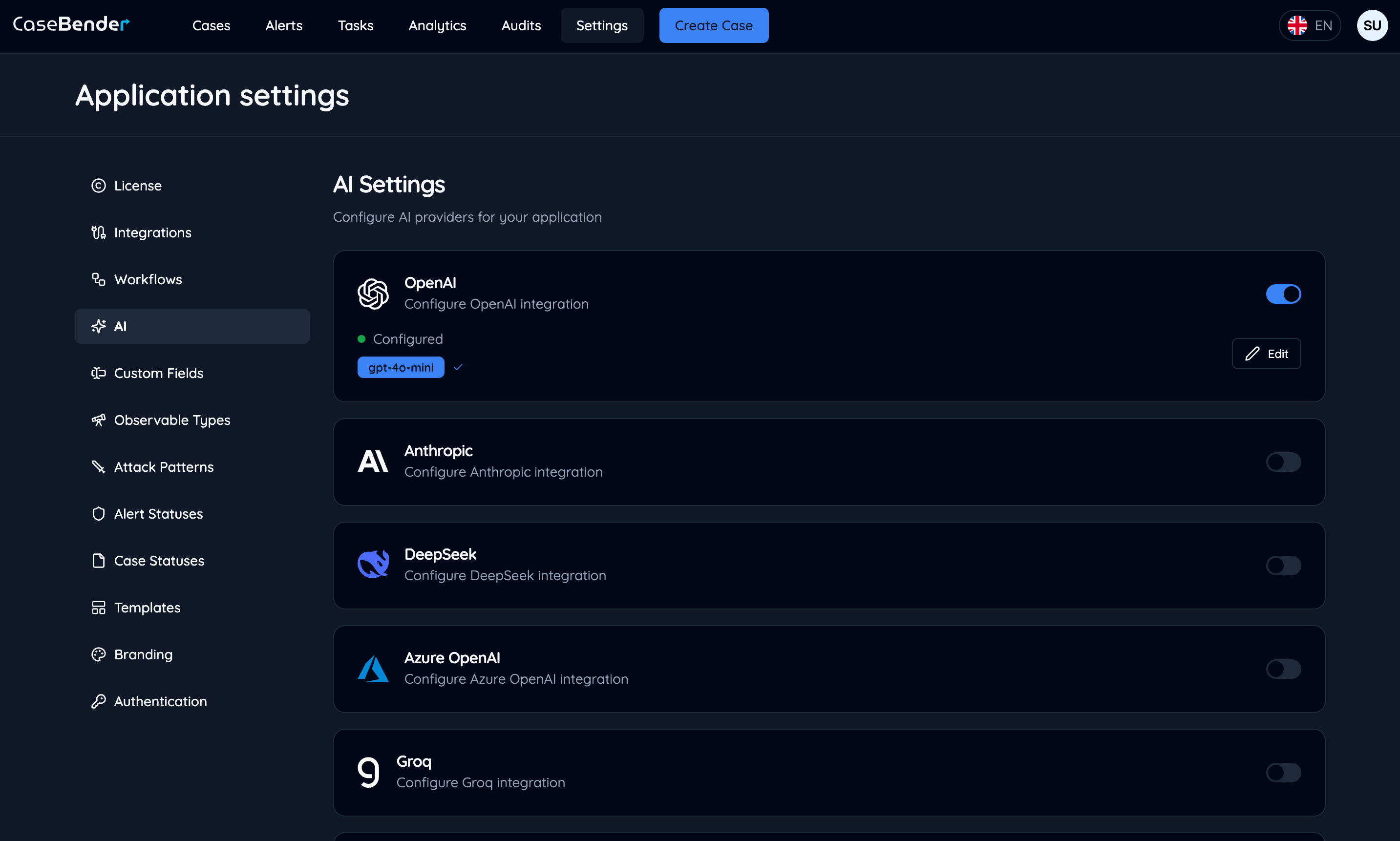

ステップ3:プロバイダー構成の完了

構成が完了すると、プロバイダーカードにアクティブステータスと構成詳細が表示されます:

- アクティブステータス

- 選択したモデル

- 使用統計

- 設定へのクイックアクセス

利用可能なプロバイダー

OpenAI

- GPT-4およびGPT-3.5モデル

- テキスト生成と分析

- コード支援

- データ抽出

Anthropic

- ClaudeおよびClaude 2モデル

- 高度な推論

- ドキュメント分析

- 複雑なタスク処理

Deepseek

- Deepseek-coderモデル

- コード生成と分析

- 技術文書

- プログラミング支援

Azure OpenAI

- マネージドOpenAIサービス

- エンタープライズセキュリティ機能

- 地域別の可用性

- 専用リソース

Groq

- LPU推論

- 超高速処理

- 高性能モデル

- 低レイテンシーレスポンス

Google AI

- PaLMおよびGeminiモデル

- マルチモーダル機能

- 高度な言語理解

- エンタープライズグレードの信頼性

xAI

- Grokモデル

- リアルタイム知識統合

- 会話型AI

- コンテキスト対応レスポンス

Ollama

- ローカルモデルデプロイメント

- カスタムモデルサポート

- オフライン処理

- リソース効率の良い推論

ベストプラクティス

セキュリティ

- APIキーの安全な保存

- 認証情報の定期的なローテーション

- API使用状況のモニタリング

- 適切なアクセス制御の設定

コスト管理

- 使用制限の構成

- トークン消費のモニタリング

- モデル固有のクォータの設定

- 使用パターンの追跡

パフォーマンス

- 適切なモデルの選択

- プロンプトエンジニアリングの最適化

- レスポンス時間のモニタリング

- タイムアウト設定の構成

メンテナンス

- プロバイダーステータスの定期的な確認

- 有効期限前のAPIキーの更新

- モデル可用性のモニタリング

- 構成の最新状態の維持

AIによって有効化される機能

ケース管理

- 自動ケース分析

- コンテンツ要約

- 優先度評価

- 関連ケースの特定

ドキュメント処理

- テキスト抽出

- ドキュメント分類

- コンテンツ分析

- 重要情報のハイライト

ワークフロー自動化

- インテリジェントルーティング

- コンテンツ生成

- 意思決定支援

- パターン認識